World Embedding: Embedding the World Into Vector

这是一个外行人的碎碎念,仅代表没有认真了解过NLP/推荐系统的非专业人士对未来的随机猜想

:本文更多的是臆想

我上大学第一节人工智能课的时候,我们的朱松纯院长就说啊,

符号落地和常识获取是笼罩在人工智能之上的两朵乌云。但似乎一切都变了,从 chatgpt 的出圈。

我们似乎找到了一种符号落地的方法。

所有的符号,有一种表示,叫做向量表示。这个世界或许也有一个表达。

前言

几个月前我和朋友在校园里闲逛,看到北京数学国际研究中心门口贴着一张海报,大概是什么时间有哪个领域的讲座能听。

……

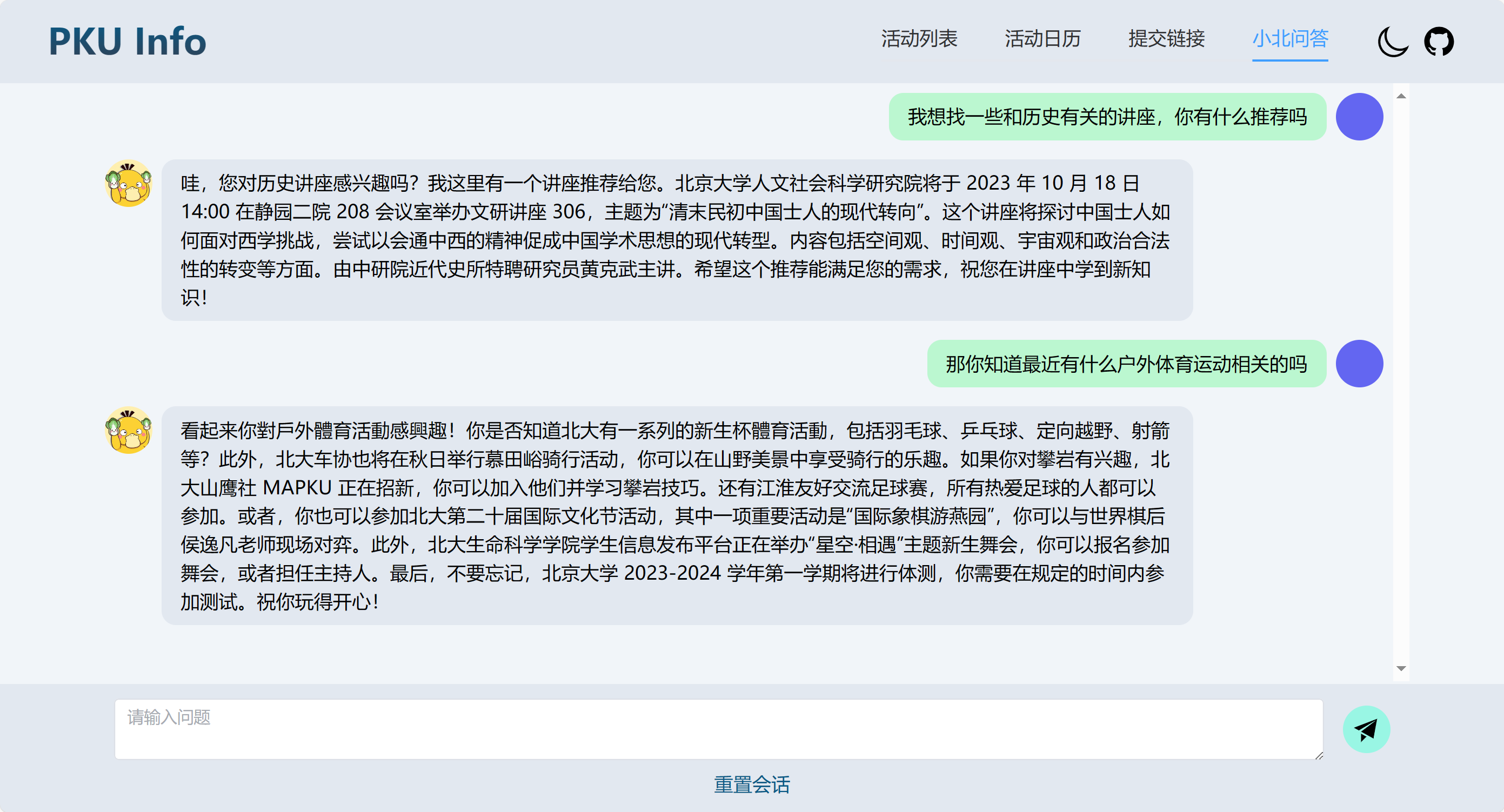

我和当时一个朋友说了这件事,从这之后发生了许许多多故事,但我这里略去。总之又是许许多多的机缘巧合,又是莫名其妙的push,然后有了一个奇怪的网页 PKU Info (lcpu.dev)。虽然代码是无比屎山的。

|

|

|---|---|

- 然后我想,诶这不就是搞了一个搜索引擎嘛,私人化部署的搜索引擎?

但再想想,好像不止。

当我们拥有了上下文的语境之后,又是一个世界了。

一些被提取出来的信息 一些被提取出来的信息 |

|

|---|---|

是的,互联网的网页固然有上下文,但拥有更多上下文的可能还是我们自己。

明天上午十点开会

倘若你看到了这一句话,怎么把它扔到数据库里呢?你还需要更多信息。

“老板在群里说”,”公司长期使用腾讯会议某固定链接作为会议链接”,“今天是2023年10月16日”,”明天上午十点开会”……

我们在生活中自然的拥有了许多的上下文,如何结合这些上下文来实现数据规格化的整理提取使用?

什么是常识,什么是语境,什么又是知识?

给了我们一个答案,一个对我们来说最轻松的答案。

所以,是什么样的答案?

原则

- 暑假的时候听一门哲学的讲座,说认知科学,神经科学,心理学,哲学,语言学,脑科学等多学科,研究着 语言,心智,大脑 的一部分。很抱歉我忘记了具体的陈述,所以会有一些偏差。但或许认知科学和神经科学更关注 心智 和 大脑,哲学和语言学会讨论 语言 和 心智 。

- 说到这里大家就明白了,基于语言模型的人工智能关心什么?关心 语言 和心智。但最近的一些前沿告诉我们,我们可以用神经科学的方法研究大语言模型,譬如可以抑制其中说谎的神经元,找到相应的空间记忆的神经元。

- 语言、心智、大脑是三位一体的。

- 我是从什么时候相信这一点的?十二月份使用

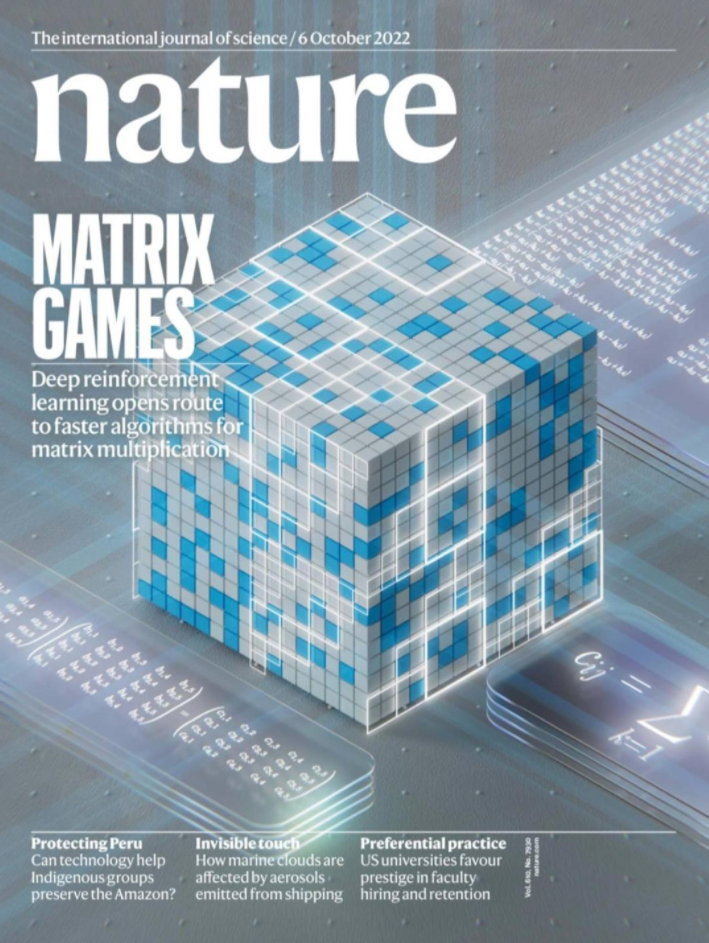

chatgpt的时候对此并没有太多印象,固然顾及不到后来有那么多靠着倒卖赚了大钱的人。但让我坚信我们对 LLM 知之甚少是 GPT4 解决了矩阵乘法优化的问题。 - 故事是说,

Deepmind在nature上发表的AlphaTensor利用强化学习的方法,优化了矩阵乘法算法,提出了一个几十年来没有改进的算法。但而后一个教授把优化问题扔给了 GPT4,GPT4也给出了优化方法,同样是优于人类过去的解法。

- 一个登上

Nature封面的工作,竟然被 AI 如此轻易地化解了?我们实在是对大语言模型知之甚少。 - 语言或许并不是直接与大脑相连的,语言蕴含着知识。就像隐马尔可夫模型中能够用动态规划推理出隐藏变量,大语言模型从语言中学到了知识。知识构成了心智。而模型学到的知识,就是向量。

- 我们或许可以说,向量表示知识,知识蕴含心智,心智理解世界。世界就是无数的向量。这似乎也符合人们对物理的理解,每一个波函数似乎也就是一个向量。但也许相比于

word-embedding,我们也可以提一嘴world-embedding。

知识的载体

- 我大学第一节计算机课是胡俊峰老师上的,老师会掏出那些传统 NLP 的论文让我们去看看,说多么神奇,多么优美,线性的对抗式语法(语义)树构建,语义提取和困惑度。

- 在那里,知识怎么被存储起来?是以树的形式。

- 过去的故事,主角名字叫做“知识图谱”。

Who Do What,形形色色的关系错综复杂,这就是知识图谱,准确,高效。知识是必要的,图谱也就必要了。 - 我上大学第一节人工智能课的时候,我们的朱松纯院长就说啊,

符号落地和常识获取是笼罩在人工智能之上的两朵乌云。 - 但似乎一切都变了,从 chatgpt 的出圈开始。至少对我说,当我重新审视

嵌入这一说法,我总觉得好像自己发现了什么。 - 知识本来就有,现在更有,一种载体,我们称之为向量。

Embedding

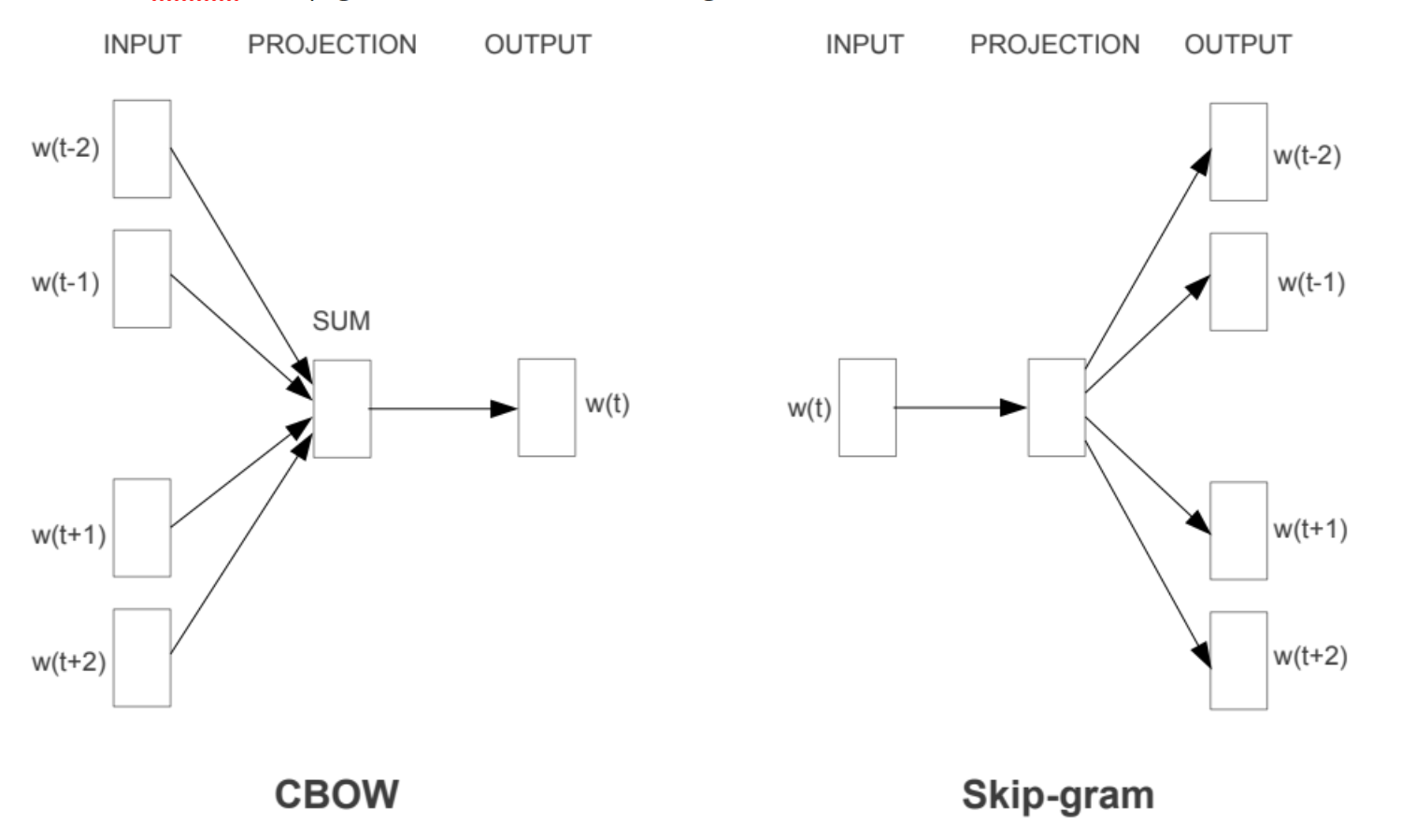

前几天翻了徐老师关于意图识别的概述,分布式表述确实是一个好的方法。稀疏向量的低维稠密表征。从NNLM,RNNLM的神经网络方法开始,到重量级的CBOW和Skip-gram两种模型,embedding。

利用上下文预测中间的词,顺便求一个向量表征。

Embedding最早被用在推荐系统里,推荐系统多么懂人类啊,懂你想要什么,懂你会沉迷什么,懂你会一直刷抖音刷下去。

好,词嵌入了,成了向量,那你怎么说,不就是一个本来一个地方为一的其它地方为零的你给压缩了一下嘛?那也就word可以embedding嘛。你说一篇文章怎么embedding?

把每个向量加起来?或许是一种方法,类似Bag of Words,但失去了更多的语义,比如上下文关系云云。在Transformer架构里的Position Embedding,或许就是人们尝试手动重新加上语义。

嘛,别那么麻烦,直接在段落中预测整句话,就像在句子中预测一个单词一样吧。(或许是,但作为一个尚未认真接触自然语言处理的人来说,还是不敢妄加断言 )

总之你看,你句子也可以embedding,断落也可以embedding。嘛然后后来 graph也可以embedding。

后来大家说 KGE 知识图谱也能嵌入,将实体和关系嵌入到低维向量空间中,同时保留KG的结构和语义信息。

万物皆可embedding,embedding之后呢?

我们说

北京 - 中国和纽约 - 美国差不多,着确实是很有意思。- 嵌入了,好,那你 embedding 得到的是什么,分布式表示?向量相似代表着语义相似,除此之外呢?你说语义的差分代表着实体的关系。好,除此之外呢?

物体的点云被嵌入成向量,关系实体都被嵌入成向量,而向量又被人类所有的语言所囊括。嵌入的向量蕴含着的,有关系,有随机鹦鹉模样的前后文模糊匹配概率分布,有图片和文字的交互,有这个世界的爱恨情仇。

这可不止是简简单单的SVD分解降维度,这可是这么大的一个万亿参数的神经网络。

向量之后的故事

- 于是我们又要说,纵然向量里有爱恨情仇,那又有什么用。

- 正如人类的思考从不会凭空想象,我们在我们的认知符号表里不断行走,进行高低层次的切换,就像行走在艾舍尔的画中。我现在想的,我之后想的,总是与我未来想的多少有点关系。

- 让我们回到有限状态自动机的故事吧,或许再增加一点混合策略的随机, 或许再多一些表带,多几个表头,有限状态自动机就可以一刻不停地运作直到停机了。

- 让我们回到随机游走的故事吧,从图的顶点出发,选一条边,再选一条边。或者再来点故事,正如向量检索的

HNSW,在可导航小世界图上因为贪心四处碰壁,但兜兜转转好像也能找到一条路。 - 发现了吗?图是离散的,有限状态自动机是离散的。向量是连续的

- 连续代表着什么?哦可多了,连续代表着智能的希望。哦,为什么就不就此打住,相信世界就是一个又一个向量的叠加呢?不妨就此相信向量就是世界呢。

符号落地

你看,符号成为了向量,知识成为了向量,世界成为了向量。

而向量数据库帮助我们找到了思维发散的方式。

从一个向量,联想到另一个向量,而它们之间确实可以被联想。

定义:c-ANN/c-k-ANN

假设 $\mathcal D$ 为数据集,有 $n$ 个点,$d$ 个维度,有一个询问的点 $q$,c-ANN search 的目的是返回一个点 $o \in \mathcal D$,使得 $dist(o,q) \le c\times dist(o^,q)$。同样的c-k-ANN是返回

top-k满足 $dist(o_i,q) \le dist(o_i^,q) , 1\le i\le k$。最无脑的方法,大概莫过于通过调包的方式,给PKU活动资讯的每一条一个高维空间的坐标,通过检索的方式,进行知识增强了。

但符号落地不限于此,向量化带给了符号新的希望。

但符号落地除了向量必然也是有路的。

朱老师想必很早就对符号和符号落地有了极其深刻的见解,只是如今的确没有认真了解过朱老师的工作。

矩阵

- 所以矩阵是什么。

应用

- 当硬件被操作系统封装,当网络被协议封装,当自然语言处理被一个API封装。一切变得清晰简单,落地也就不远了。当几个手无寸铁的本科生可以自己写一个(假装可以)自然交互搜索引擎的时候,也就会发现 AI 落地不远了。企业助手,个人助理,这些似乎都毫无技术难度,如今没有见到推广,却也不远了。前沿的AI技术很多,但没有人推广。妙鸭相机的技术一年前就成熟,但却没有人试图做成产品。世界还是太缺人了,到处缺人,各种人。

- 但总之,我说服我自己向量是一个很有意思的东西了。最近想很学基于LSH的向量检索,希望能多少看一点。