pairwise XXO

WHEN IS RL BETTER THAN DPO IN RLHF? A REPRE SENTATION AND OPTIMIZATION PERSPECTIVE

Shadow Alignment

Preference Fine-Tuning of LLMs Should Leverage Suboptimal, On-Policy Data

- mode-seeking,而不是 mode-covering

DPO

形式

解释:

- 使用闭式解优化带KL约束的,用最大似然估计的方法推。

观点1:使用偏导数理解

DPO的如果有一个loss,是不是chosen和rejected是同时增加或者减小?

定义 $\pi+=\pi(a+\mid x),\pi-=\pi(a-\mid x),z=\pi-/\pi+$

- 定义 $\alpha=(\pi0(a+\mid x)/\pi0(a-\mid x))^\beta$,则常数 $C=\alpha\beta /(1+\alpha z^\beta)z^{\beta-1}$

- 容易发现两者的符号是不一样的,chosen理应增加,rejected理应减少。但是当 $\pi+<\pi-$ 的时候,两者的reward都会增加,当 $\pi+>\pi-$ 的时候,两者的reward更倾向于减少。

观点2:

- DPO可以理解成一个最大熵强化学习里面的Q function

为什么DPO的reward恰好就是一个log的?log会不会产生什么问题?

- llama3.1的报告里指出可以加一个nll loss的trick。

FPO

SLiC-HF

形式

或者可以加一个reg的penalty

评价

- 暂时不知道怎么理论推导写成这样。

- hinge lossvariation of DPO

在训练时,SLiC仅需要来自参考模型的采样输出,而DPO则需要来自该(冻结的)参考模型的对于正负序列的逻辑回归值。

RSO

形式

- 虽然也是优化同一个目标函数,但是采用不是从当前policy中采样,也不是从sft中采样,而是利用拒绝采样的方法从先学到的reward function所构造的policy $\pi_r$ 中采样。

- 所以先构造了一个reward model (preference model),形式如下,然后让reward小但是sft大的部分获得采样的概率更低。

评价

- 确实DPO保证的是如果收敛,在最后的时候能满足训练出来的reward是对的,但是中间过程没有训好的情况下,不一定implicit reward就是对的。

IPO

形式

定义

首先认为

证明这是唯一的一个最优的东西,然后这里的 $\mu$ 是一个策略,然后通过一系列推导得到一个基于采样的无偏等价形式:

解释

DPO 的一个缺点是它在人类偏好数据集上很快就会过拟合。为了避免这种情况,谷歌 DeepMind 的研究人员引入了身份偏好优化(IPO),这种方法为 DPO 损失添加了一个正则,能够在不使用「提前停止」等技巧的情况下让模型收敛。

DPO的问题说是chosen的概率高于rejected的概率,如果 $y’$ 一定比 $y$ 差, $\pi(y’)/\pi(y)\to 0$,那么无论正则化系数是多少都会变成 $\pi(y’)\to 0$。

直观理解的话,这是一个尝试减少 $\log (\pi(yw)/\pi(y_l))$ 和 $\log (\pi{ref}(yw)/\pi{ref}(y_l))$ 之间的差,使得他们变成 $\tau^{-1} / 2$。这个 $\tau$ 是一个调整和 ref 以及 optimal policy 之间差别的系数,系数越大就越接近ref,越小就越接近optimal policy(也就是DPO的那个最优形式)

实验结果里Figure2显示了DPO对unseen的内容会下降,而IPO没问题,应该是一开始训练的时候DPO能让chosen的reward和reject的reward都增加(?)想象一下一开始DPO的loss是

所以比如一开始的时候两个东西都是一样的概率,两边都是1,得到$-\log 0.5$,

评价

这个参数怎么调比较好啊,像是多了一个自由度。

IPO-MD

- online IPO多一个preference model,然后online地采样就算online IPO,文章说能证明online IPO就是一个self-play求nash均衡的问题。证明在appendixC

所以

忘记哪个了

用大模型来猜这个优化函数是什么,然后让测一下结果看哪个最好,改后继续改,忘记哪篇文章了。

TDPO

形式

where

解释:

- 观察发现 $y-$ 偏离 $\pi{ref}$ 的速度比 $y_+$ 偏离的速度要快,加了一些per token的KL的约束。

评价:

- 不知道这个KL约束能不能对DPO的数据集外色散问题有一些帮助。思考了一下就是偏导求得时候还要算上后面得KL项,直观来看的话是 $\pi_+$ 的partial会减小。

$KL(P;Q)$ 对 $Qj$ 的梯度是 $-P_j/Q_j$ ,所以 $y+$ 的梯度上会加一项 $1/\pi_+ $,好像并没有什么用。总的中间的梯度应该是

那么假设 $\pi+$ 很大,$\pi-$ 很小,两个ref也是常数,也没什么用,但至少一开始如果 $\pi{ref}(y+)$ 比较小,这个梯度的值就比较大。

所以结论是没有帮助,不过这东西不一样的点在于它是token level的,还是得有用的。

online DPO

公式

评价

- 看了一个百川的工作之后觉得onlineDPO的好处应该是on policy。

ORPO

simPO

形式:

或者是

评价

- 看不懂,但在知乎上有大佬在喷(?)

- 一般理性而言 $y_w$ 会比 $y_l$ 短一点?所以效果才会比较好,是这样吗。然后log ratio平均在 $-5$ 的样子,

非pairwise的

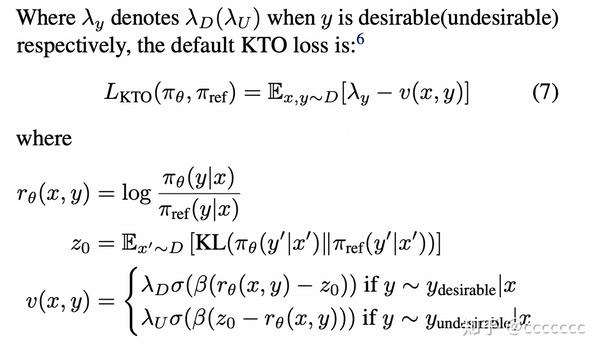

KTO

形式

然后说明DPO和SLIC都是特例,$r\theta =\beta \log \frac{\pi\theta(y\mid x)}{\pi{ref}(y\mid x)}$ 或者 $r{\theta}=\log p_\theta(y\mid x)$

于是定义了KTO

Remax

- 入门RLHF的第一篇文章,强推

形式

- 先采样一条轨迹,算一个reward,然后通过贪心采样得到另一条轨迹,得到一个baseline的reward用于降低方差。然后用最简单的reinforce算法来优化这个算法。

评价

- 如果只是bandit的setting,确实是不需要critic model的。

DPO的limitation

- 3D-Properties: Identifying Challenges in DPO and Charting a Path Forward 是一个很好的总结了,说gradient descent下,正例和负例的梯度尺度不匹配导致了DPO的三种问题。